上传Robotstxt文件至网站根目录,方法依据网站建站系统和服务器架构而异通常通过主机管理面板或FTP上传至网站文件目录上传后,可直接在浏览器访问域名robotstxt查看文件内容测试Robotstxt文件的正确性,可利用搜索引擎站长工具,如Google Search Console的Robotstxt测试工具将网站添加到Google Search;2检查网站代码元标签是否拥有h1h6altb等元标签,这些是收录抓取使用 3检查并创建sitemap网站地图,在网站中形成网站内链易蜘蛛抓取 4检查并修改robotstxt文件外部链接需要禁止蜘蛛抓取避免蜘蛛流出 5网站需要进行站长平台提交更容易更快的被搜索引擎收录抓取 6网站内部文章高;1什么是外链? 外链就是指从别的网站导入到自己网站的链接导入链接对于网站优化来说是非常重要的一个过程导入链接的质量即导入链接所在页面的权重直接决定了我们的网站在搜索引擎中的权重 外链的名称分很多,有导入链接有外部链接,也有很多人喜欢叫反向链接,其实反链和外链是有区别的 2什么是反链;4 增加外部链接通过与其他高质量网站建立外部链接,可以引导搜索引擎蜘蛛爬行到你的网站,从而提高收录速度5 利用社交媒体推广在社交媒体上分享你的网站内容,不仅可以吸引更多的访问者,还能增加搜索引擎发现你网站的机会6 合理设置Robotstxt通过合理设置Robotstxt文件,告诉搜索引擎哪些页面。 新奥资料免费精准期期准

2025新奥开门奖查询 Robotstxt 是一个由网站管理员或系统创建的文件,主要目的是向搜索引擎爬虫指示网站页面抓取的规则通过“allow”和“disallow”指令,文件告诉“user agents”用户代理哪些页面应该被访问,哪些不应被访问如果网站上传了 robotstxt 文件,搜索引擎爬虫就会根据文件指示抓取网页如果网站没有上传;正确使用GoogleYahoo等搜索引擎所提供的站长工具,设置好您的网站,可以大大提高网站的可见度和排名同时,设置正确的robotstxt文件,有助于搜索引擎更好地抓取您的网站内容,提高收录效率与质量较好的网站建立友好的链接,可以增加网站的权重,提高搜索引擎排名优化网站的结构,确保网站的导航清晰;1博客要经常更新,保证每周至少更新两次,新鲜的内容有利于搜素引擎的排名2使用静态化HTML文件,每一篇日志都创建一个HTML文件,对于ZBlog来说,还可以启用“月光静态插件”将目录存档也做成静态HTML文件,静态文件不仅仅能应付更大的访问量,也对SEO有一定帮助3启用ZBlog的Google Sitemaps插件。

提升网站效率合理配置robots标签可以避免搜索引擎蜘蛛爬取不必要的页面,减少服务器的负担,提升网站的整体性能和效率符合搜索引擎规范遵循搜索引擎的抓取规范,使用robots标签进行网站内容的抓取控制,有助于建立良好的网站与搜索引擎之间的关系,提升网站的搜索排名和可见性综上所述,SEO引擎优化确实;操作检查robotstxt文件是否设置正确,确保重要页面被允许访问,同时阻止不必要的文件或目录被索引优化点击率较低的页面 分析原因点击率较低的页面可能存在问题,如内容布局不合理关键字密度不当外链接不足或SEO关键字设置不准确等操作对这些页面进行逐一分析,找出问题所在并进行相应的调整,如优化内容布局增加关键字;5使用sitemap和robotstxt使用插件googlexmlsitemapsxxx高,domaincomxxxhtm高8丰富的内部链接和外部链接内部链接是搜索引擎蜘蛛爬页面的一个很重要的部分,应尽量使用文字链接,尽量不使用js内的链接好的内部链接可以整体提升站内搜索引擎的排名有价值的外部链接对搜索引擎的排名也很。

新手尤其要注意这一点,那么这个时候你就会问,到底什么时候网站优化完,再去进行站外的链接建设比较好?这里不得不提到一个“沙盒”sandbox的概念 什么是“沙盒”?简单一句话,进入沙盒的网站是搜索引擎要考察你这个网站是不是作弊了很多老站长都有这个经历,大量快速的做站群,然后取得网站的收录;我们的站长们有很多刚开始的时候为了了解如何进行网站优化,可能会去各大seo论坛站长论坛进行学习交流,这也是一种学习的方法,但是你在上面学到的东西不一定对自己的网站有帮助,有时候运用的时候也会遇到小小的问题seo论坛上面讲到的东西有一些是站长们的经验确实值得我们学习借鉴,有一些东西也只是;3 打造高效的内链网络 合理设置内部链接在新内容中设置内部链接,引导搜索引擎蜘蛛从其他页面快速访问新内容,提高秒收效率 使用内容之间的权重分享法建立站内链轮,有助于蜘蛛快速爬行到最新发布的内容4 利用外部资源提升权重 建设高质量外链通过购买高质量外链或与相关网站建立友链,提升网站的权重和搜索引擎可见度 高人气论坛分享。

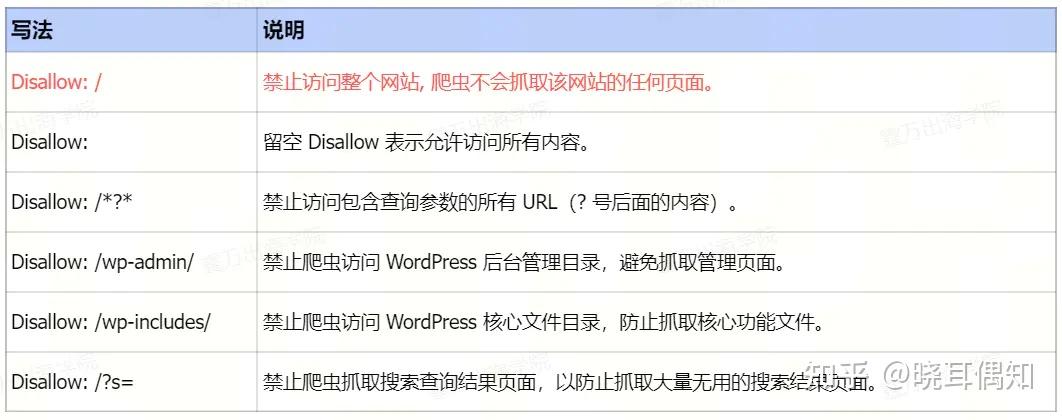

或者创建一个空文件robotstxt 若禁止所有搜索引擎访问整个网站,则应设置UseragentDisallow 若禁止访问网站的几个部分,比如010203目录,则应设置UseragentDisallow 01 Disallow 02 Disallow 03 若禁止某个特定搜索引擎访问,如BadBot,则应设置Useragent BadBot;1需要先设置网站tdk这是抓取重点一但设置,不能随意修改 2检查网站代码元标签是否拥有h1h6altb等元标签,这些是收录抓取使用 3检查并创建sitemap网站地图,在网站中形成网站内链易蜘蛛抓取 4检查并修改robotstxt文件外部链接需要禁止蜘蛛抓取避免蜘蛛流出 5网站需要进行站长平台;网站改版或URL重写优化时原来不符合搜索引擎友好的链接需要全部屏蔽掉采用robotstxt文件删除旧的链接符合搜索引擎友好一些没有关键词的页面,比如本站的这个页面,屏蔽掉更好一般情况下,站内的搜索结果页面屏蔽掉更好。

转载请注明来自中国金属学会,本文标题:《如何利用robots.txt进行SEO优化_外部链接建设有什么方法》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...