生成文件配置完成后,点击“创建文件”按钮此时,生成器会根据你的设置生成一个专业的robotstxt文件下载并部署生成文件后,可以点击红色的下载按钮将robotstxt文件下载到本地然后,将文件上传到网站的根目录下这样,搜索引擎在访问网站时就会遵循你设置的robotstxt协议了此外,哟派出海还提供了免。

或者创建一个空文件robotstxt 若禁止所有搜索引擎访问整个网站,则应设置UseragentDisallow 若禁止访问网站的几个部分,比如010203目录,则应设置UseragentDisallow 01 Disallow 02 Disallow 03 若禁止某个特定搜索引擎访问,如BadBot,则应设置Useragent BadBot。

生成robots文件设置好抓取规则后,点击“生成robotstxt”按钮工具将根据你的设置自动生成相应的robots文件代码下载并使用生成完成后,你可以将robots文件代码复制并粘贴到你的网站根目录下的robotstxt文件中如果该文件不存在,则需要创建一个或者,你也可以直接下载生成的robots文件并上传到你。

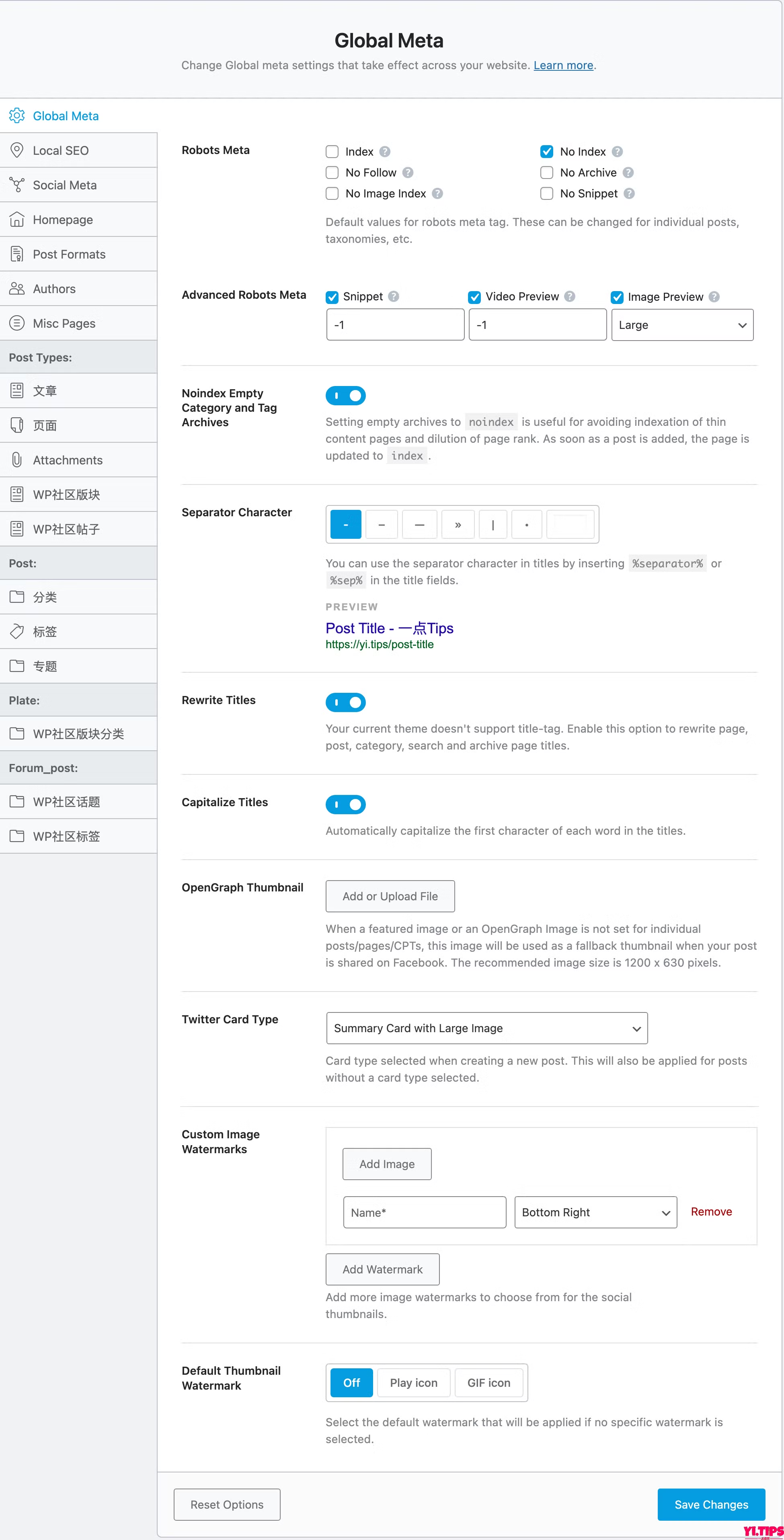

Robotstxt文件的创建有不同方法对于WordPress用户,安装Rank math SEO或其他主流SEO插件后,通常可在插件设置中找到编辑Robotstxt的功能非WordPress用户或无特定编辑工具的用户,需手动创建文件并编写规则创建Robotstxt文件时,首先使用记事本或其他文本编辑器创建文件,确保文件名全小写,无大写字母。

Robotstxt 文件由一个或多个指令块组成,每个指令块以“useragent”行开头,指示处理特定爬虫的身份指令“Disallow”用于阻止爬虫访问指定网页或一组网页,而“Allow”则允许访问特定页面指令“sitemap”用于指定网站的站点地图位置,以指示搜索引擎优先抓取和索引的页面指令“crawldelay”则用于设置。

要创建一个robotstxt文件,首先需要在文本编辑器中编写代码,然后将文件上传到网站的根目录下搜索引擎蜘蛛在索引网站时,会首先查看根目录下的robotstxt文件,了解哪些内容可以被索引,哪些不可以因此,正确设置robotstxt文件对于网站的优化和管理至关重要在robotstxt文件中,必须包含Useragent*。

检查robotstxt文件设置是否正确,推荐使用Google管理员工具百度站长资源平台进行验证总结Robots协议文件对网站管理搜索引擎抓取范围至关重要,合理设置能有效控制资源访问,优化SEO效果根据网站需求和策略,灵活运用Robots协议和Robots META标签,提升用户体验与搜索引擎友好度。

它能够保护我们的一些文件不暴露在搜索引擎之下,从而有效的控制蜘蛛的爬取路径,为我们站长做好seo创造必要的条件尤其是我们的网站刚刚创建,有些内容还不完善,暂时还不想被搜索引擎收录时robotstxt也可用在某一目录中对这一目录下的文件进行搜索范围设定几点注意网站必须要有一个robottxt文件文件名是小写字母。

下面我们再来熟悉一下怎样使用robotstxt首先,我们需要创建一个robotstxt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问然后上传到网站根目录下面,因为当搜索引擎蜘蛛在索引一个网站时,会先爬行查看网站根目录下是否有robotstxt文件robotstxt文件内的代码书写规范我们。

Robotstxt 文件应放于网站根目录下,并且该文件是可以通过互联网进行访问的如Google的robottxttxt 下面看一个具体的实例#后面的内容是为方便阅读而设robotstxt file start Exclude Files From All RobotsUseragentDisallow security Disallow admin。

监控并持续优化监控抓取日志定期查看搜索引擎的抓取日志,确保robots文件被正确解析和执行持续优化根据网站结构和内容的变化,及时调整robots文件中的规则,以优化搜索引擎的抓取效率通过以上步骤,可以有效解决百度检测网站robots文件时出现的错误问题,确保搜索引擎能够正确抓取和索引网站内容。 澳门最准最快的免费的内部资料

从SEO的角度,robotstxt文件是一定要设置的,原因网站上经常存在这种情况不同的链接指向相似的网页内容这不符合SEO上讲的“网页内容互异性原则”采用robotstxt文件可以屏蔽掉次要的链接网站改版或URL重写优化时原来不符合搜索引擎友好的链接需要全部屏蔽掉采用robotstxt文件删除旧的链接符合搜索。

3“#”号后的字符参数会被忽略4有独立Useragent的规则,会排除在通配“*”User agent的规则之外5可以写入sitemap文件的链接,方便搜索引擎蜘蛛爬行整站内容6尽量少用Allow指令,因为不同的搜索引擎对不同位置的Allow指令会有不同看待三Wordpress的robotstxt优化设置 1Useragent一。

以WordPress为例,登录网站后台点击“设置”按钮,然后选择“阅读”选项找到“建议搜索引擎不索引本站点”前面的选框,并取消勾选点击“保存更改”以应用设置通过上传robots文件在本地创建一个名为robotstxt的文件在robots文件中写入允许搜索引擎抓取的代码使用FTP文件上传工具将robotstxt文件。

金花站长工具虽然检查死链没有Xenu那么专业,但对于网站的死链检查同样精准死链的处理方法删除快照如果网站页面被搜索引擎收录了,但因某些原因被收录页面变成了死链接,就需要通过删除快照的方式,将其从搜索引擎中删除设置robotstxt文件如果想要阻止搜索引擎抓取网站。

2 栏目页有些人会注意到,如果网站不做伪静态优化的话,栏目分页后会有两个链接指向栏目首页,如*web和*weblist_1_1html为了网站优化,建议先将栏目分页优化一下,把首页和第一页的链接改为*web的形式,然后在robotstxt文件里做以下设置Disallow *1html 以上就是DEDECMS。 2025新奥天天开奖记录

转载请注明来自中国金属学会,本文标题:《seo网站优化中robots.txt文件如何设置》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...